说明

- 本文为(【SEO】01-网站如何做可控的SEO?)[https://blog.onlyfew.cn/2020/05/31/guoping-seo-01/] 中对应的案例,对照阅读效果更好。

- 案例来源为张国平老师的SEO课程,关注公众号“支离书”后台回复“SEO课程”可免费获得课程。

案例正文

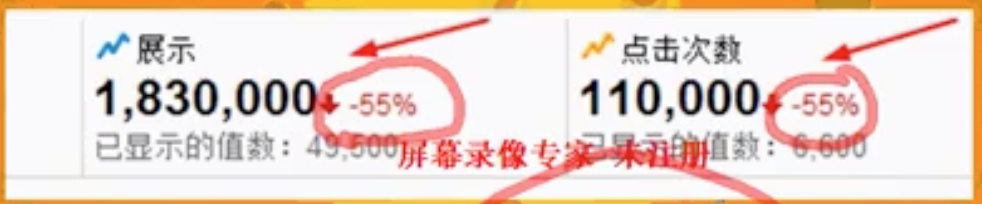

1、现象:到元旦跌到了高峰期的1/4

2、经验:节假日最多跌一半的流量,不会跌到1/4

3、初步分析原因:

1)查看收录量:

- 现象:收录量确实跌了

- 经验:收录量的绝对值没什么意义(百度和谷歌均是),要看趋势

2)查看排名

- 现象:排名没有跌,反而有些涨了

- 经验:排名也要想办法数据化

3)查看点击率

- 现象:点击率没有变化

- 经验:点击率 = 点击次数 / 展示次数

- 说明:展示次数包括在每一页的展示,不管是排在第几页,只要用户点到了对应页,展示出来的都会计数

根据公式1可知,流量跌的原因是收录量跌导致的。

再根据公式2分析,因为节假日期间页面内容没做任何变化,所以可以肯定是搜索引擎抓取量降低导致的。

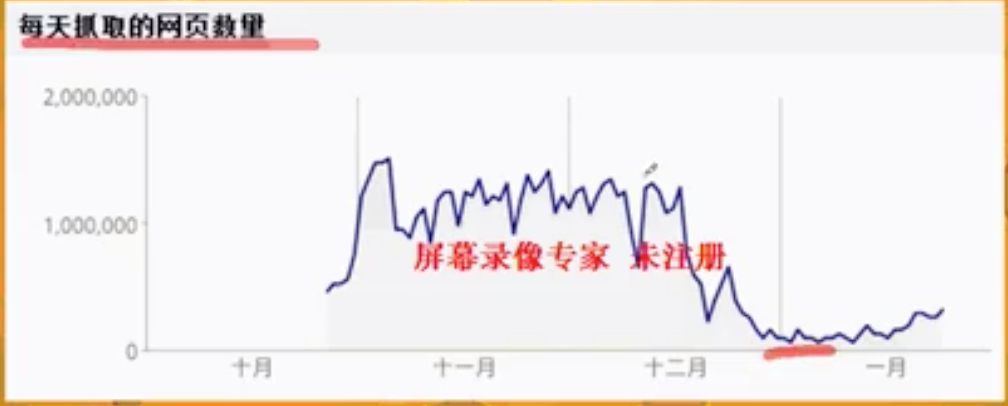

4、用数据验证原因

经验证,抓取量确实跌了

5、那么抓取量为什么跌了?

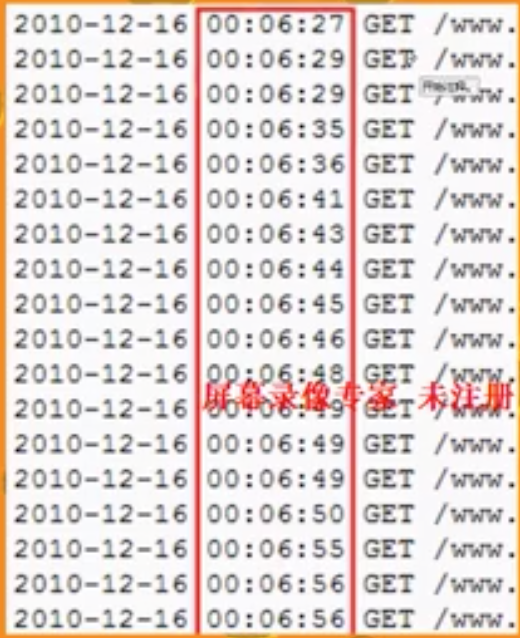

经验:爬虫抓取可以在服务器记录日志,通过分析日志可进行进一步分析

经验:利用对比法找原因,对比抓取量正常时候的服务器日志和抓取量异常时的服务器日志

经验:上图中每一行是一个爬虫,所有行累加即为所有的抓取量

此步结论:总抓取量的下跌是因为单个爬虫的抓取下跌导致的

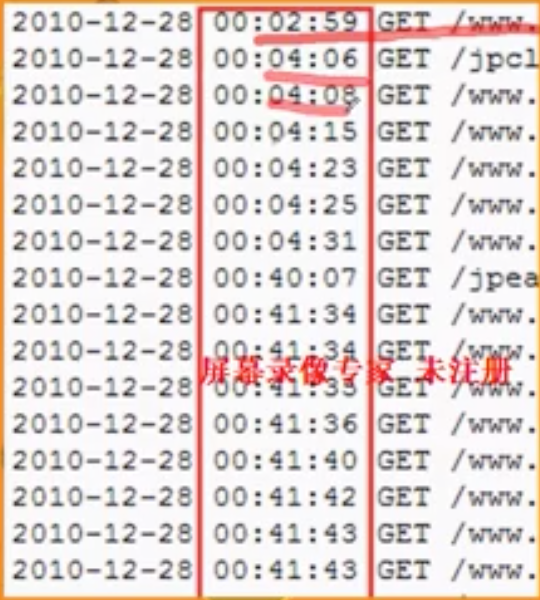

6、继续分析,为什么单个爬虫的抓取下跌了呢?

经验:继续利用细分法,分析单个爬虫的正常时和异常时的日志

此步结论:单个爬虫的抓取确实下跌了,原因是单个爬虫的抓取间隔变大了许多倍,单位时间内抓取的页面数量变少了很多

7、为什么单个爬虫的爬取间隔变大了许多倍呢?

这个问题,数据层面可分析的就没有了,要解答这个问题需要依靠经验,下面是几个可能导致这种情况案例:

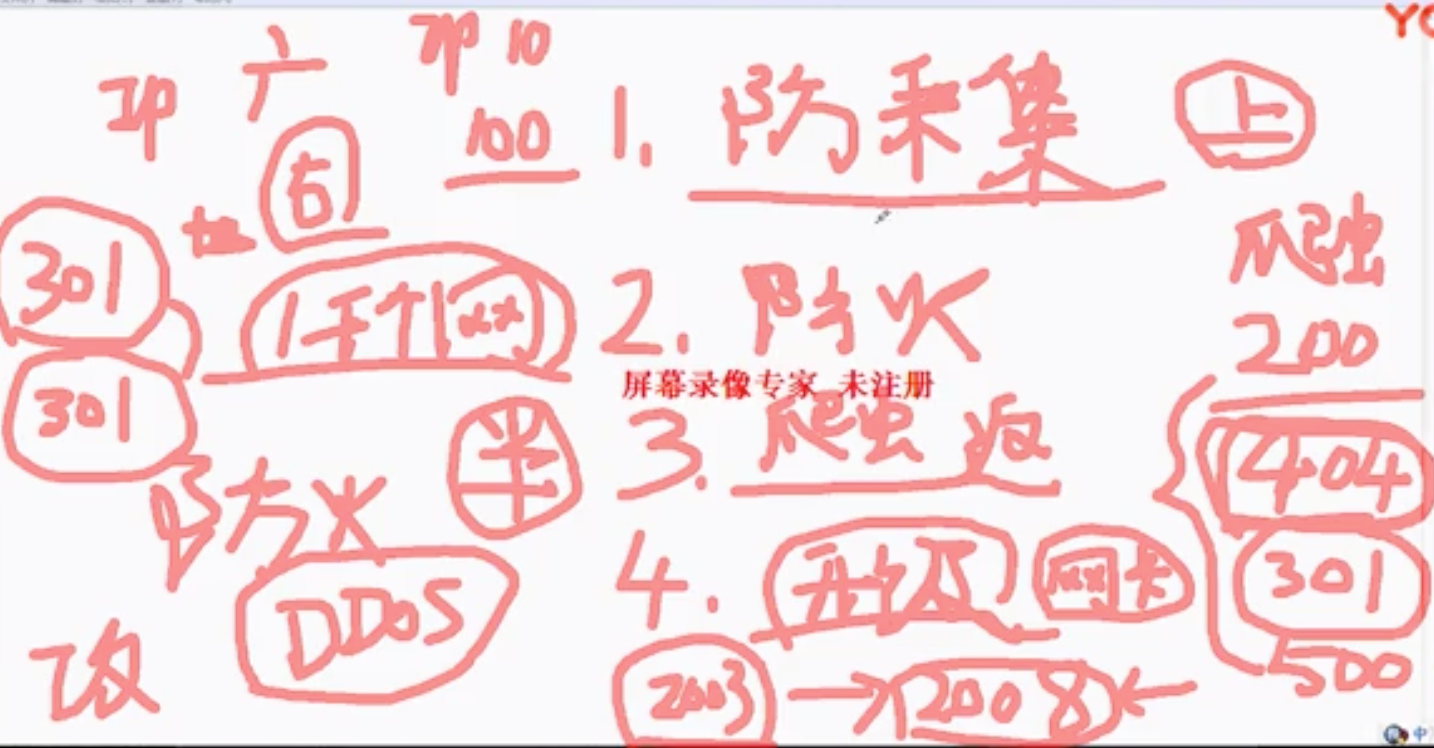

- 网站是细分行业头部网站,为了防止竞争对手爬取资源,业务部门上线了防采集系统(5分钟访问1千次标记异常),导致爬虫也中招了;

- 技术部门为了防止网站被DDOS,设置了防火墙规则(比如10秒钟100个页面),导致爬虫也中招了;

- 网站连续返回2个及以上的状态码(比如404之后301再200),会导致爬虫不爬了,爬虫的规则是301跳转一次是ok的,再多一次也不会爬了;

- 服务器升级,windows server 2003升级到windows server 2008后网卡自动变为半双工状态,导致请求在网卡排队,速度变慢;

老师在遇到上面情况时立即从上面案例的经验去排查,结果都不是上面的原因,然后叫相关同事开会(主要是开发和运维),然后发现运维做了一个服务器虚拟化的改动,但是虚拟化之后的配置非最优状态,即将物理机虚拟化3台虚拟机后但是共用一块硬盘,硬盘转速不变的同时要供应3个人同时访问,导致访问速度变得很慢,性能变差。

8、找到上面的原因解决后,流量立即上涨了: